-

28

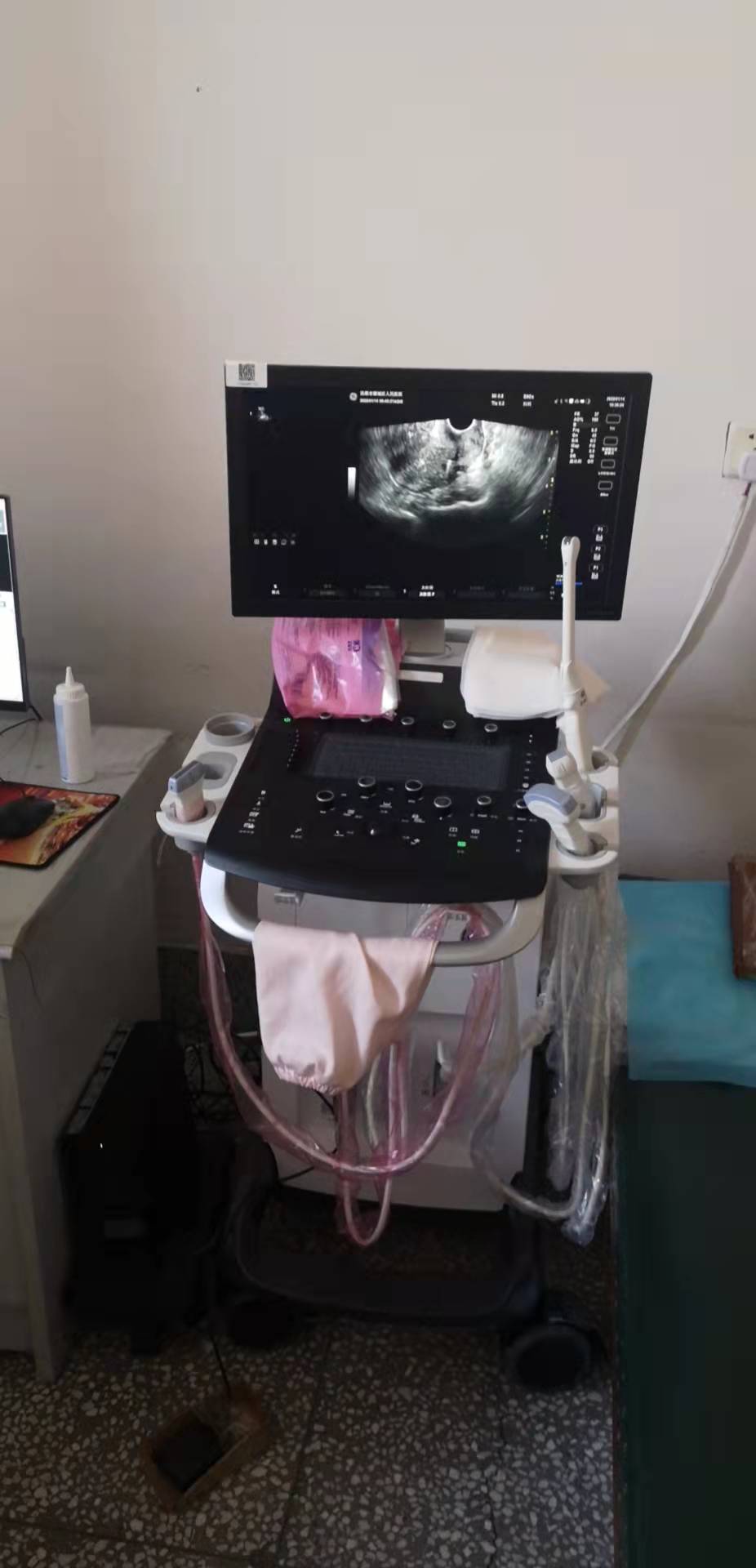

2025-02三八節(jié)婦科體檢優(yōu)惠活動(dòng)進(jìn)行時(shí)

遠(yuǎn)離婦科疾病1宮頸癌篩查3·8HPV+TCT 原價(jià):517元 活動(dòng)價(jià):198元2女性腫瘤標(biāo)志物3·8AFP+CEA+CA19-9+CA15-3+CA125原價(jià):220元 活動(dòng)價(jià):132元3男性腫瘤標(biāo)志物3·8AFP+CEA+CA19-9+TPSA+CA125原價(jià):220元 活動(dòng)價(jià):132...

-

14

2024-11【世界糖尿病日】順城區(qū)人民醫(yī)院開(kāi)展糖尿病日宣傳活動(dòng) 撫順市順城區(qū)人民醫(yī)院 2024年11月14日 14:51 遼寧

2024年糖尿病日宣傳主題是“糖尿病與幸福感”。這一主題強(qiáng)調(diào)了糖尿病不僅影響身體健康,還會(huì)影響患者的心理狀態(tài)和社會(huì)福祉。通過(guò)提高公眾對(duì)糖尿病的認(rèn)識(shí),提倡健康的生活方式,加強(qiáng)糖尿病的預(yù)防和管理,可以提升糖尿...

-

18

2024-07熱烈慶祝中華人民共和國(guó)中醫(yī)藥法實(shí)施七周年

歡迎訪問(wèn)“撫順市順城區(qū)人民醫(yī)院”官方網(wǎng)站!

024-5760 3266

024-5760 3266

遼公網(wǎng)安備

21041102000408號(hào)

遼公網(wǎng)安備

21041102000408號(hào)